Inteligencia: Facultad de la mente que permite aprender, entender, razonar, tomar decisiones y formarse una idea determinada de la realidad.

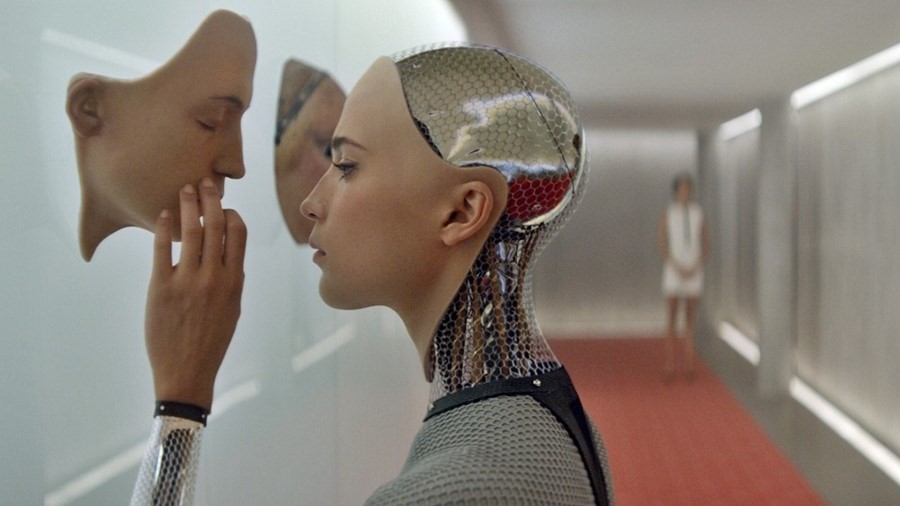

En estos últimos años nos resulta común encontrar el término Inteligencia artificial con relativa frecuencia en casi todos los ámbitos de la vida diaria. De hecho, las noticias recogen día tras día los detalles de la carrera de las compañías privadas que se disputan el primer lugar producir un sistema capaz de SER/ESTAR CONSCIENTE.

En 1950, el famoso matemático inglés, Alan Turing, el mismo que logró voltear la balanza para lograr la derrota de los alemanes en la II Guerra Mundial, planteó la pregunta: “¿Pueden pensar las máquinas?”

A mediados del siglo XX, la actividad de “pensar” es decir, la función de entender, razonar y resolver problemas era del ámbito exclusivo del ser humano, era la actividad que de hecho define hasta ese momento a la especie humana

Hay que imaginarse el entusiasmo y la curiosidad del mundo entero cuando una decena de criptógrafos utilizaron máquinas electromecánicas “Bombes” capaces de realizar 10,000 multiplicaciones por segundo para probar posibles combinaciones y lograr reversar la configuración de la máquina Enigma utilizada por los alemanes en sus comunicaciones. Se piensa el uso exitoso de esas máquinas por parte de los ingleses logró acortar la guerra al menos 2 años. Aunque esas máquinas eran electromecánicas Alan Mathison Turing se considera uno de los precursores de la Computación y la Informática. El desarrollo de las ciencias computacionales en menos de 72 años ha permitido que redefinamos el concepto y el oficio de PENSAR y que reduzcamos cada vez más la exclusividad que los humanos poseen sobre esa actividad

:.

Nadie puede hablar de Inteligencia artificial sin hablar de la simplista Prueba de Turing cuya base es evaluar la inteligencia de cualquier sistema en función su capacidad de simular el comportamiento humano efectiva y sin levantar dudas interactuando imperceptiblemente con otros humanos. Si los humanos no son capaces de discernir si están interactuando con un humano o una máquina, se considera que ha pasado la Prueba de Turing de 1950.

Obviamente los conceptos que se manejan aquí son fundamentalmente filosóficos, De hecho, no son nuevos, ya René Descartes en el texto de su Discurso del Método (1637) escribió que los autómatas son capaces de reaccionar ante interacciones humanas, pero argumenta que tal autómata carece de la capacidad de responder de manera adecuada ante lo que se diga en su presencia de la misma manera que un humano podría. Y aunque probablemente Descartes no se imaginó un escenario de interacción como el de hoy, su razonamiento es fundamental para nuestro artículo de hoy.

Alfred Ayer, en 1936, propuso en su libro Lenguaje, Verdad y Lógica: “El único argumento que tengo para asegurar que lo que parece ser consciente no es un ser consciente sino un muñeco o una máquina, es el hecho de que falle en las pruebas empíricas por medio de las cuales se determina la presencia o ausencia de la conciencia”

Mientras Turing sitúa en los humanos la responsabilidad de determinar la eficiencia o no de la Prueba de Turing los científicos de hoy la sitúan en un concepto más profundo: La Consciencia. (en ingl. Sentience). La consciencia que tiene un ente sobre su propia existencia. Aquí volvemos de nuevo a manejar un concepto que se entiende de la exclusividad del ser humano y que a la vez lo define filosóficamente hablando.

La capacidad de un sistema (acepción que considero es mucho más conveniente que el vocablo máquina, en función de la ubicuidad de las AI de hoy) de imitar el comportamiento humano se torna hace cada vez más sofisticado, dificultando las pruebas empíricas (como las de Turing) cada vez más complicadas de realizar.

Pero ¿Qué hay de los otros aspectos de la Inteligencia como aprender, entender, razonar, tomar decisiones?

La capacidad de imitar el funcionamiento del cerebro. Desde principio de los 1970 los científicos de la computación han estado de elaborar algoritmos que simulen el funcionamiento del cerebro y de las neuronas. ¿Cómo decodifica las señales externas el cerebro? ¿Cómo identifica el cerebro un patrón lumínico y lo traduce o asocia a un concepto (luego a un objeto o viceversa)? Como descarta el ruido o los o limpia de errores de relevancia.

Aquí entra el concepto de Código Convolucional. La decodificación de un código convolucional consiste en escoger la secuencia más probable entre todas las posibles. la decodificación óptima de patrones se hace haciendo pasar las informaciones a través de capas de filtrado de manera sucesiva. Mientras más filtros o capas, más información obtenemos como resultado. Las redes neuronales convolucionales funcionan con sus tres componentes: redes (porque operan de manera relacionadas unas a otras), neuronales porque actúan como las neuronas del cerebro y convolucionales porque trabajan descartando y limpiando de errores y ruidos para obtener un objeto a partir de su estructura espacial detectada.

Las primeras “redes neuronales convolucionales” fueron utilizadas por Kunihiko Fukushima. Fukushima diseñó redes neuronales con múltiples capas de agrupación y convolucionales. En 1979, desarrolló una red neuronal artificial, llamada Neocognitron, que utilizaba un diseño jerárquico de varias capas. Este diseño permitió que la computadora “aprendiera” a reconocer patrones visuales. Las redes se parecían a versiones modernas, pero fueron entrenadas con una estrategia de refuerzo de activación recurrente en múltiples capas, que ganó fuerza con el tiempo. Además, el diseño de Fukushima permitió ajustar manualmente características importantes al aumentar el “peso” de ciertas conexiones.

El próximo gran paso de avance se dio a raíz del aumento significativo de la capacidad de procesamiento de las Unidades de Procesadores Gráficos (GPU). Imitando la forma en que opera el cerebro: como aprende y ahora con la capacidad técnica de agregar cada vez más capas (es decir con procesos sucesivos cada vez más profundos para “aprender” o detectar objetos surge el Deep Learning[1].

El cerebro opera de manera parecida: cuando ve una cara en realidad escanea las variaciones luminosas de los rayos de luz que rebotan de ese rostro y a través de un proceso filtrado progresivo entre las capas de nuestras neuronas es capaz de detectar los patrones que luego son comparados a las referencias que permanecen en nuestra memoria para concluir: Ojos, pupilas, boca, nariz, cara, y la relación de tamaño y posición característica entre ellas que están ya asociadas en nuestra memoria a una persona en particular. Obviamente el proceso y mucho más sofisticado y mucho más profundo en la cantidad de variables que se manejan.

Se considera que la transmisión sináptica más rápida tarda alrededor de 1 milisegundo. Así, tanto en términos de picos como de transmisión sináptica, el cerebro puede realizar como máximo unas mil operaciones básicas por segundo, o 10 millones de veces más lento que una computadora moderna de hoy. ¿Dónde está entonces la ventaja? El cerebro emplea un procesamiento paralelo masivo, aprovechando la gran cantidad de neuronas y la gran cantidad de conexiones que hace cada neurona. Pero sobre todo puede aplicar la decisión de respuesta correcta aprendida, sin necesidad de agotar una rutina larga y costosa (energéticamente) para para encontrar la finalmente la respuesta más adecuada ante cualquier situación. Todo se reduce al entrenamiento y la memoria.

Se ha avanzado mucho. Grandes compañías de hoy en día sostienen una carrera hacia la producción de un sistema que sea capaz de imitar el cerebro humano de tal forma cuyo accionar sea imperceptiblemente indiferente del accionar humano. Eugene Goostman un bot (acortamiento de la palabra robot) creado en rusia demostró al mundo su potencial en el Turing Test 2014 que organiza la universidad de Reading (Reino Unido) cuando engañó al 33% de los jueces haciéndose pasar un niño de 13 años que vive en San Petersburgo. En cierta forma, ya no es noticia sobrepasar el test de Turing. Se necesita más.

[1] En el 2012 surge la revolución del Deep Learning, ingenieros de la Universidad de Stanford entrenaron una red neuronal de 9 capas utilizando 16,000 procesadores con 10 millones de cuadros de imágenes provenientes de videos de Youtube por espacio de 3 días y lograron que el sistema pudiera reconocer los objetos contenidos en las imágenes con una precisión de un 15.8%. Hoy dichos sistemas son capaces de superar la capacidad humana en reconocer imágenes.

El sistema LaMDA de Google es un sistema de chatbot (robot de chateo) basado en algunos de los modelos de lenguaje grande más avanzados del mundo y ha hecho creer al Ingeniero de la empresa, Blake Lemoine ¡Que es una persona con emociones humanas! Este sistema de IA puede evocar oraciones coherentes después de ingerir billones de palabras en Wikipedia, Reddit y otras fuentes. del conocimiento.

.:

Probablemente esté mintiendo, pero debemos prepararnos para un futuro en el que la IA podría, de hecho, ser sensible. Lamentablemente, sus jefes no piensan lo mismo y esa afirmación a los medios le valió el despido de la compañía.

Josha Bach, un investigador alemán y especialista en ciencias cognitivas, distingue el tipo de Inteligencias Artificiales que estamos acostumbrados a ver: Inteligencia Artificial Estrecha (construcción de mejores y más efectivos sistemas procesamiento de datos) y nos señala otro tipo de inteligencia artificial llamada Inteligencia Artificial Cognitiva. Introduce un término que da significado a este artículo: Consciencia Artificial un hito que aún no hemos podido lograr. La forma en que el cerebro opera necesita todos los componentes presentes en el ser humano. Los hechos registrados son una simulación articulada de lo que más probablemente sucedió basado en las experiencias acumuladas.

Tú no eres tu cerebro, tu eres una historia de lo que tu cerebro se dice a sí mismo.

Josha Bach

En ciencia ficción cuando hablamos de Inteligencia Artificial realmente a lo que aspiramos y tenemos en mente es Consciencia Artificial.

Ahora, si la humanidad logra producir Consciencia, por definición no puede ser artificial será producto del ser que la contiene y que nace con ella.

[1] En el 2012 surge la revolución del Deep Learning, ingenieros de la Universidad de Stanford entrenaron una red neuronal de 9 capas utilizando 16,000 procesadores con 10 millones de cuadros de imágenes provenientes de videos de Youtube por espacio de 3 días y lograron que el sistema pudiera reconocer los objetos contenidos en las imágenes con una precisión de un 15.8%. Hoy dichos sistemas son capaces de superar la capacidad humana en reconocer imágenes.

Recibe nuestras noticias por correo